1936

Alan Turing, pubblica “On Computable Numbers” (Numeri non calcolabili), introducendo il concetto di “macchina di Turing“: una rappresentazione astratta di un dispositivo di calcolo che esplora la portata e i limiti di cio’ che puo’ essere calcolato.

1943

I ricercatori crearono il primo computer moderno: una macchina elettronica, digitale e programmabile. Da qui nacquero domande fondamentali: le macchine possono pensare? Possono essere intelligenti? Potranno mai essere intelligenti?

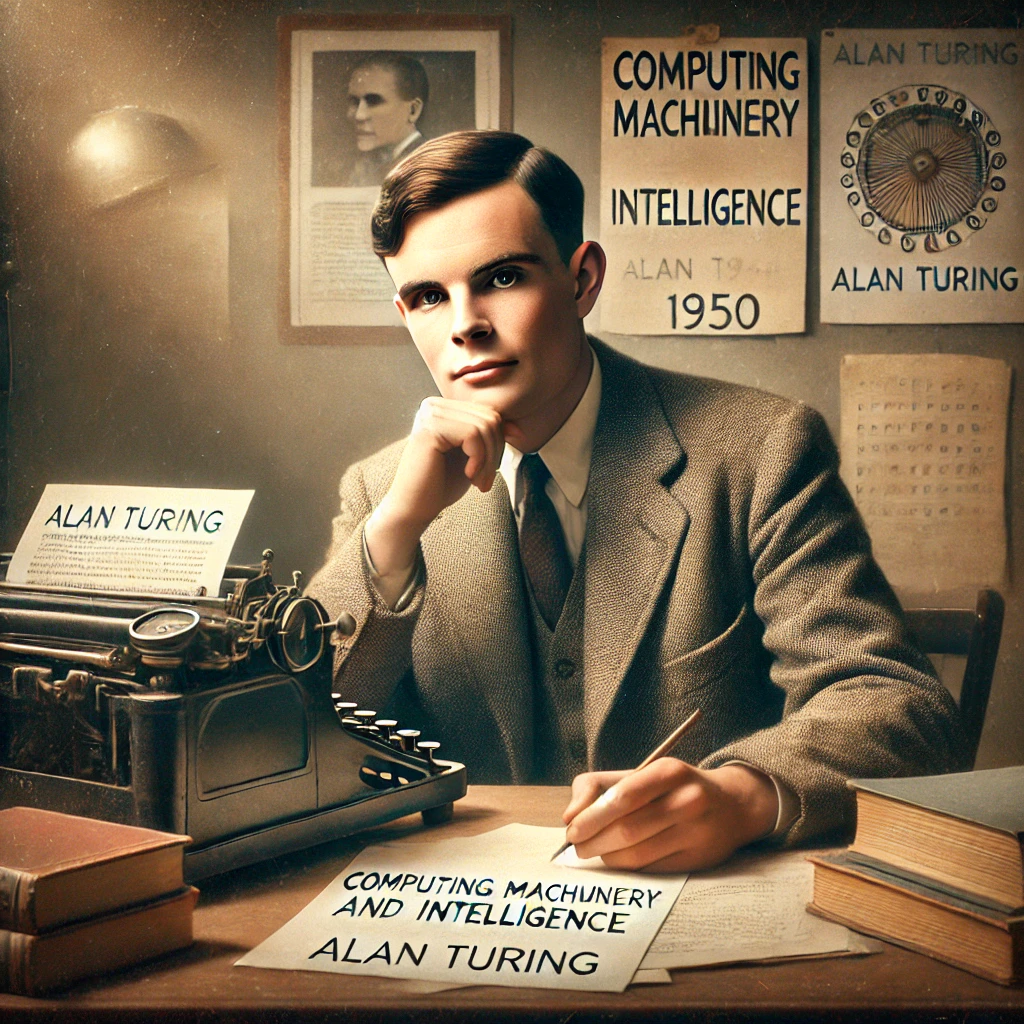

1950

Alan Turing, nell’ articolo “Computing Machinery and Intelligence”propone di tralasciare il problema dell’intelligenza delle macchine poiche’ cio’ che conta e’ non il meccanismo bensi’ la manifestazione dell’intelligenza.

Turing sostiene: “se una macchina opera in modo talmente efficiente che gli osservatori non sono in grado di distinguere il suo comportamento da quello di un essere umano, allora la macchina deve essere considerata intelligente”.

Turing propone il celebre “Test di Turing” secondo cui un computer capace di formulare risposte indistinguibili da quelle che darebbe un essere umano, dovrebbe essere considerato una macchina intelligente.

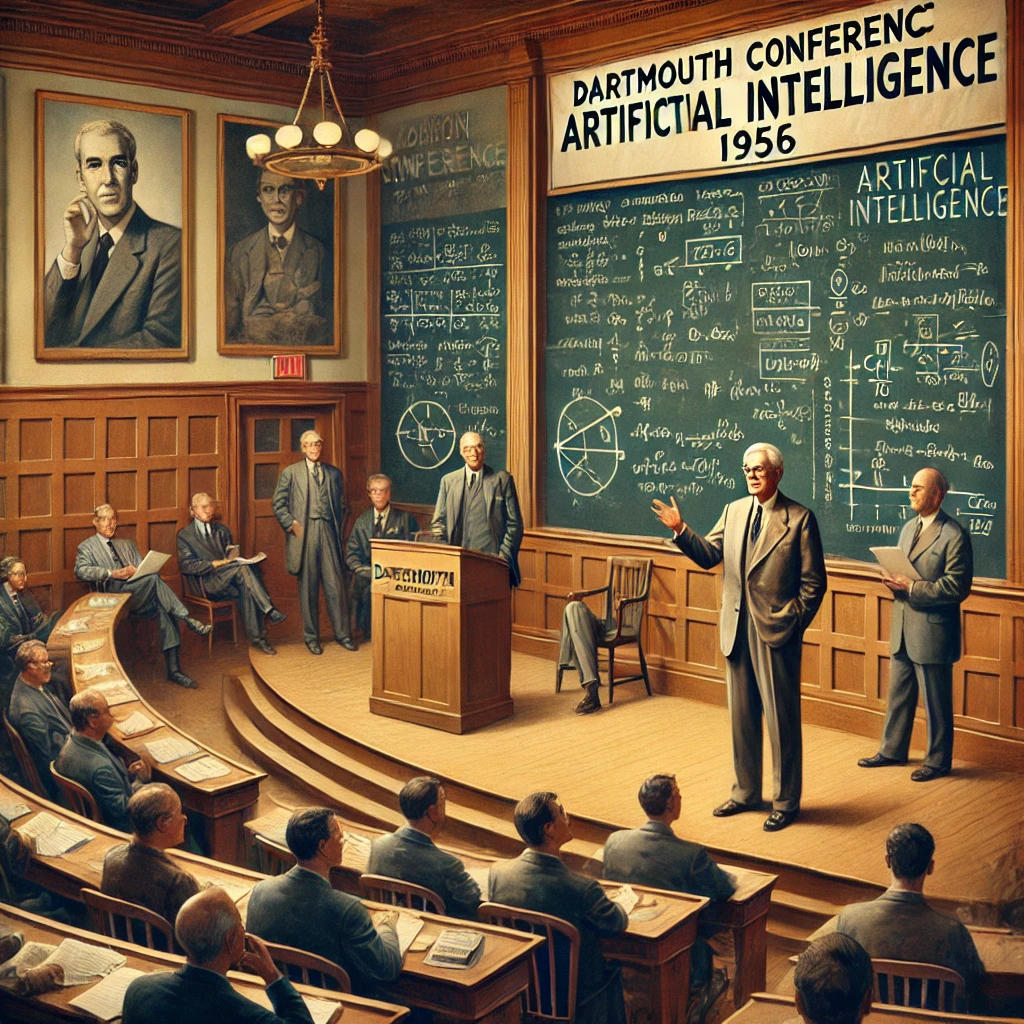

1956

Lo scienziato informatico e matematico John McCarthy organizza una conferenza di Dartmouth College per esplorare la possibilita’ di creare delle macchine pensanti. Durante l’evento conia l’espressione “intelligenza artificiale”, definendola come la capacita’ delle macchine di svolgere compiti caratteristici dell’intelligenza umana”.

1966

Joseph Weizenbaum crea ELIZA, uno dei principali chatbot (assistente virtuale). Il programma imita l’atteggiamento comprensivo e attento di una terapeuta, risultando particolarmente convincente.

1968

Il computer HAL 9000, il computer protagonista del film “2001: Odissea nello spazio” di Stanley Kubrick, scritto in collaborazione con Arthur C. Clarke, influenzera’ profondamente l’immaginario collettivo sull’intelligenza artificiale.

1969

Marvin Minsky e Seymour Papertpubblicano “Perceptrons“, un’analisi dei limiti e delle potenzialita’ delle reti neurali, modelli ispirati al cervello umano che elaborano informazioni attraverso ‘neuroni’ artificiali. Il libro evidenzia limiti importanti, come l’incapacita’ di risolvere problemi non lineari, e contribuisce al primo ‘inverno dell’IA’, ma getta anche le basi per future ricerche su reti neurali piu’ avanzate.

Anni Settanta

Il decennio del cosidetto ‘inverno dell’IA’. A seguito della pubblicazione di due rapporti molto pessimistici, commissionati dai governi statunitense e britannico, i finanziamenti pubblici per la ricerca nel campo dell’ intelligenza artificiale furono drasticamente ridotti.

I due documenti chiave furono:

- 1966, “Preliminary Discussion of the Artificial Intelligence Problem”, redatto dall’ ARPA (Agenzia per i Progetti di Ricerca Avanzata, poi conosciuta come DARPA).

- 1973, “The Lighthill Report”, commissionato dal governo britannico

1980

Si tiene all’ Universita’ di Stanford, negli Stati Uniti, la prima conferenza nazionale dell’Associazione americana per l’intelligenza artificiale (AAAI), evento che segna un passo importante nella diffusione e nel riconoscimento dell’IA come disciplina scientifica

1997

Il supercomputer Deep Blue di IBM sconfigge il campione mondiale di scacchi Garry Kasparov, segnando un traguardo importante nell’intelligenza artificiale.

In una delle partite, Deep Blue compie una mossa inattesa che lascia kasparov profondamente disorientato. Questa mossa, interpretata inizialmente come una strategia avanzata, potrebbe essere stata il risultato di un errore di calcolo. Tuttavia, il gesto ha dimostrato come una logica priva di emozioni e preconcetti possa sorprendere anche i giocatori piu’ esperti, aprendo il dibattito su una possibile “logica superiore” che supera quella umana.

2011

IBM Watson vince al quiz televisivo di cultura generale Jeopardy! contro i due migliori campioni della trasmissione.

Il gioco consiste nel formulare la domanda corretta partendo da una risposta fornita. L’intelligenza artificiale ha dimostrato come una macchina potesse interpretare e rispondere a un gioco basato su conoscenze generali e sulla comprensione del linguaggio, una competenza che richiede abilita’ complesse.

2014

Il chatbot Eugene Goostmansviluppato dal russo Vladimir Veselov(residente negli Stati Uniti), e dall’ucraino Eugene Demchenko(residente in Russia), supera una versione del Test di Turing.

Eugene Goostman e’ progettato per simulare un ragazzo ucraino di tredici anni. Sebbene accolto con scetticismo dalla comunita’ scientifica, questo risultato ha portato attenzione mediatica al potenziale del chatbot e dell’intelligenza artificiale conversazionale.

2016

AlphaGo sviluppato da DeepMind, sconfigge il campione mondiale di Go, Lee Sedol, in una serie di partite storiche.

Il go e’ un antico gioco strategico, originario dell’Estremo Oriente, conosciuto per la sua complessita’ e imprevedibilita’, considerata molto superiore a quella degli scacchi. La vittoria di AlphaGo rappresenta un traguardo straordinario per l’intelligenza artificiale, ottenuto grazie all’uso di reti neurali profonde e apprendimento per rinforzo, che permettono all’IA di affrontare problemi complessi e imprevedibili.

Un momento iconico della sfida e’ stato la ‘Mossa 37’ nella seconda partita: una mossa apparentemente illogica per i giocatori umani, ma straordinariamente efficace, che ha lasciato Lee Sedol e gli esperti di Go profondamente sorpresi. Questo ha dimostrato come l’IA possa trovare soluzioni innovative che sfuggono anche ai migliori giocatori umani. Tuttavia, Lee Sedol ha avuto il suo momento di gloria nella quarta partita, quando ha sorpreso AlphaGo con la ‘Mossa 78′, costringendo il sistema a un errore e vincendo la partita. Questa vittoria ha dimostrato che, nonostante i progressi dell’IA, la creativita’ e l’intuizione umana conservano ancora un valore unico.

La sconfitta contro AlphaGo e’ stata un’esperienza emotivamente intensa per Lee Sedol, che ha riflettuto sulla natura del gioco e sul futuro delle competizioni tra uomo e macchina. La sfida tra AlphaGo e Lee Sedol e’ diventata simbolica, evidenziando i punti di forza e i limiti dell’intelligenza umana e artificiale.

2018

L’IAdi Google, Duplex, riesce a prenotare un appuntamento dal parucchiere e a chiedere informazioni a un ristorante parlando al telefono come un cliente qualunque.

Duplex utilizza una tecnologia avanzata di comprensione e generazione del linguaggio naturale, inclusi elementi come le pause e le inflessioni vocali, per rendere la conversazione estremamente realistica.

Questa dimostrazione ha mostrato le capacita’ dell’IA di interagire in contesti quotidiani, sollevando al contempo questioni etiche sulla trasparenza nell’uso delle macchine nelle interazioni umane.

2020

OpeAI rilascia GPT-3, un’intelligenza artificiale basata su un modello di linguaggio di grandi dimensioni (LLM, Large Language Model), che, al momento del suo lancio, rappresentava il modello linguistico piu’ potente mai creato, con 175 miliardi di parametri.

GPT-3 ha mostrato capacita’ sorprendenti nel generare testo, rispondere a domande e produrre contenuti creativi, aprendo nuove prospettive per l’IA.

2022

OpenAI lancia DALL-E 2, un modello di intelligenza artificiale in grado di generare immagini a partire da descrizioni testuali, mostrando una nuova frontiera della creativita’ assistita dall’AI.

Nello stesso anno, viene rilasciato ChatGPT, una variante di GPT-3 ottimizzata per interazioni conversazionali, capace di dialogare in modo naturale e fornire risposte dettagliate su una vasta gamma di argomenti.

2023

OpenAI rilascia GPT-4, una versione ancora piu’ avanzata e sofisticata del suo modello di linguaggio, capace di comprendere e generare testi con maggiore precisione, contestualita’ e coerenza.

GPT-4 di distingue per la sua capacita’ di gestire conversazioni piu’ complesse, rispondere a domande tecniche con accuratezza superiore e interpretare sfumature linguistiche che migliorano l’interazione con gli utenti.